Passend zum kürzlich an dieser Stelle erfolgte Hinweis von Kollega Haber zum zahlenbasierten Charakter digitaler Geschichte hat Mills Kelly in seinem Blog an drei einfachen Beispielen erläutert, wie er die neue Funktion Ngram Viewer aus den Google Labs in seinen Einführungskursen zu verwenden beabsichtigt. Den Studierenden könne er so einen ersten Einblick in die Möglichkeiten statistischer Auswertungen von historischen Texten verschaffen.

Der vom Ngram Viewer erschlossene Fundus besteht aus einer Auswahl von 5.2 Millionen Bücher aus den rund 15 Millionen in Google Books gescannt vorliegenden Publikationen. Dieser Fundus umfasst 500 Milliarden Wörter in Englisch (361 Mia Wörter), Französisch (45 Mia), Spanisch (45 Mia), Deutsch (37 Mia), Russisch (35 Mia), Chinesisch (13 Mia) und Hebräisch (2 Mia). ((eine genaue Aufteilung der Bücher auf die verschiedenen Sprachen ist weder auf der Erläuterungsseite noch im Beitrag im Google-Books-Blog noch im soeben erschienenen Science-Artikel zu finden)) Kelly zeigt mit einigen Beispiel-Abfragen, wie anhand des unterschiedlichen Vorkommens von Begriffen im Lauf der Jahrhunderte Fragen an die kulturelle Bedeutung von Begriffen und deren Wandel gestellt werden können.

Die Graphen selbst, so hält er fest, vermögen hierzu keine Antworten zu geben. Auch verweist Kelly auf gewisse Vorbehalten gegenüber dieser Form der statistischen Auswertung von publiziertem Material, zu der (unter Umständen relevante) Kontextdaten fehlen. Doch betont Kelly seine Überzeugung, dass diese Einführung mit dem Ngram Viewer aus den Studierenden wohl noch keine Statistiks-Cracks à la Edward Tufte macht, aber doch als ein erster Schritt zu einer spielerischen, explorativ-erprobenden Auseinandersetzung mit den Möglichkeiten der Datenanalyse im digitalen Zeitalter dienen könne, gemäss Steve Ramsays Überlegungen zu einer „hermeneutics of screwing around„.

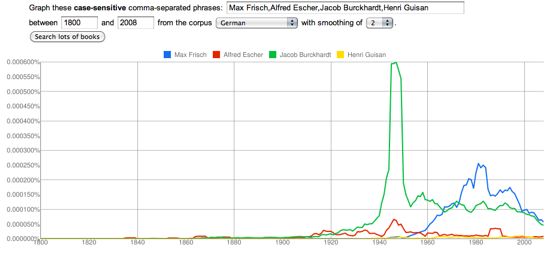

P.S. Der Graph zu Beginn des Eintrags (hier eine Grossansicht) zeigt die Verteilung des Vorkommens der Namen einiger Schweizer Persönlichkeiten: Henri Guisan, Alfred Escher, Max Frisch und Jacob Burckhardt. Es ist zwar erfreulich, dass der Historiker Burckhardt hier obenaus schwingt – die Häufung des Vorkommens in den 1940er Jahren deutet aber darauf hin, dass hier ein statistischer Artefakt vorliegt.

Unbedingt als Ergänzung zu empfehlen: Dan Cohens Anmerkungen zum Ngram Viewer und seiner Bedeutung für die Arbeit der digital historians. Das umfasst nicht nur eine leicht ironische, zugleich aber die Leistungen würdigende Auseinandersetzung mit dem Begriff „Culturomics“, den die Autoren um Jean-Baptiste Michel in besagten Science-Artikel geprägt haben. Cohen erwägt auch die Vor- und Nachteile dieses Datenbestandes, dabei bedauert er vor allem die fehlende Möglichkeit, die Granularität zu wechseln, also im Detail, in den einzelnen Büchern, die Verwendung der Begriffe zu klären. Ausserdem plädiert er deutlich dafür, sich weniger auf einzelne Begriffe (unigrams) oder Begriffspaare (bigrams, oft Namen) zu konzentrieren, sondern 4- oder 5-grams anzuwenden (also anders, als in meinem hier angeführten Beispiel mit bekannten Schweizer Persönlichkeiten).

Hier noch der komplette Nachweis des noch nicht publizierten, aber bereits akzeptierten und online freigeschalteten Science-Artikels:

Michel, Jean-Baptiste et al.: Quantitative Analysis of Culture Using Millions of Digitized Books, in: Science Online, 16. Dezember 2010, Science DOI: 10.1126/science.1199644, Verfügbar unter http://www.sciencemag.org/content/early/2010/12/15/science.1199644 (20.12.2010).